4. Computación afectiva

https://doi.org/10.52501/cc.096

Karina Mariela Figueroa Mora

María Lucía Barrón Estrada

Ramón Zatarain Cabada

Dimensions

4. Computación afectiva

Las emociones son sentimientos humanos asociados al estado de ánimo, temperamento, personalidad, disposición y motivación. Pero también, se relacionan con hormonas como la dopamina, noradrenalina y serotonina. La motivación conduce y dinamiza el comportamiento, mientras que la emoción proporciona el componente afectivo a la motivación, ya sea positiva o negativa.

Las emociones son elementos prominentes que siempre están presentes en la mente humana (Picard, 1995). Expresar emociones al comunicarse oralmente es una manera de complementar la información que el orador nos está dando. Esta información adicional complementa lo que está explícito en el mensaje lingüístico. Paul Ekman fue pionero en realizar estudios sobre los efectos de las emociones en el habla y sus relaciones con las expresiones faciales (Ekman, 1999). Sin embargo, en los últimos años, científicos de la computación han trabajado con el problema del reconocimiento automático de emociones, por medio de la clasificación de éstas usando técnicas de reconocimiento de patrones.

Conocer el estado emocional de un individuo permite recabar información relevante acerca de su estado psicológico; con esta información, un sistema tutor inteligente tiene más capacidad para interactuar con una persona y responder a sus necesidades. Los sistemas computacionales que realizan reconocimiento automático de las emociones pueden perfeccionar el desempeño, usabilidad y, en general, la calidad de interacción humano-computadora para sus usuarios; por ejemplo, mejorar el aprendizaje de los estudiantes o el servicio de atención a clientes, entre otras aplicaciones.

Por otro lado, en las últimas décadas, los sistemas tutores inteligentes (sti) han incorporado la capacidad para reconocer y manejar el estado afectivo del estudiante, además de la identificación tradicional de su estado cognitivo. Estos sti cuentan con dispositivos y sensores especiales para medir y monitorear rasgos faciales, conductividad de la piel, tonos o características en la voz, entre otras señales, y con ello reconocer o identificar el estado emocional o afectivo del estudiante (Conati & Maclare, 2004; D’Mello et al., 2007; Arroyo et al., 2009). Sin embargo, esta área de investigación —la computación afectiva—, con menos de 30 años, aún se encuentra en desarrollo pues tradicionalmente los sti fueron concebidos y diseñados para medir estados cognitivos sin incluir el estado afectivo o emocional (Carbonell, 1970; Clancey, 1979; Anderson et al., 1990; Aleven & Koedinger, 2002; Woolf, 2009).

La investigación en el área de computación afectiva incluye detección y respuesta a algún afecto. Mientras que en los sistemas que detectan afecto se identifican emociones como frustración, interés o aburrimiento, en los sistemas de respuesta a afectos se intenta transformar los estados emocionales negativos como la frustración o el aburrimiento en un estado emocional positivo como el de interés.

4.1 Definición de emoción y afecto

Una emoción, según la Real Academia Española (rae, 2011) se define como “la alteración del ánimo en forma intensa y pasajera, agradable o penosa, y que va acompañada de cierta conmoción somática”. Por otra parte, la Asociación Americana de Psicología (apa por sus siglas en inglés) ofrece la definición de emoción como “un patrón de reacción complejo, que involucra elementos experienciales, conductuales y fisiológicos, mediante el cual un individuo intenta lidiar con un asunto o evento personalmente significativo” (APA, 2021).

Para distinguir emoción de afecto y sentimiento se ofrecen las siguientes definiciones (Stathopoulou & Tsihrintzis, 2010):

Afecto: Se define como un patrón de comportamiento observable el cual es la expresión de un estado de sentimiento o emoción subjetivamente experimentado (Association AP, 1984).

Sentimiento: Es una sensación que ha sido probada contra experiencias previas y ha sido etiquetada. Los sentimientos son aprendidos durante la vida de una persona, son personales y biográficos ya que cada persona tiene un conjunto diferente de sensaciones previas de las cuales atraer mientras se interpretan y se etiquetan los sentimientos (Deleuze & Guattari, 1988).

Emoción: Son consideradas como la proyección/manifestación de un sentimiento, y generalmente, una respuesta cognoscitiva a la información de la periferia. A diferencia de los sentimientos, la proyección de emociones puede ser genuina o fingida (Ekman, 1972).

Algunas de las emociones básicas más comúnmente aceptadas son: ira, disgusto, miedo, felicidad, tristeza y sorpresa.

4.2 Categorización de las emociones

Existen muchas teorías psicológicas que tratan de explicar y clasificar a las emociones. De acuerdo con Wundt (2008), los estados emocionales se clasifican en tres dimensiones: 1) placer/codicia-desagrado/no-codicia, 2) emoción-tranquilidad, y 3) esfuerzo/tensión-relajamiento. Otra representación popular es el espacio “excitación-placer” que describe a la emoción como negativa, por ejemplo el enojo, o como positiva, como la felicidad.

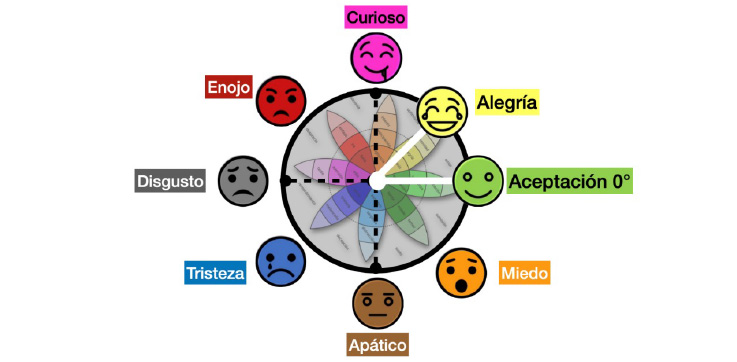

Otra categorización de las emociones es lo que se conoce como “la rueda de las emociones” (Plutchik, 1980). En este caso, las emociones se distribuyen en un círculo y sus características se manejan como medidas de ángulos (figura 15). Las emociones en los extremos de cada eje van de lo negativo a lo positivo (por ejemplo, de apático a curioso).

Figura 15. Rueda de emociones

Fuente: Adaptación de Plutchik (1980).

Para el desarrollo de un sistema de software que reconozca emociones, resulta conveniente elegir un modelo con un número pequeño de emociones básicas. Ekman en su trabajo sobre análisis facial de expresiones (1999) describe un subconjunto de emociones que incluye sorpresa, miedo, alegría, enojo, disgusto/desprecio e interés, las cuales han sido utilizadas en sistemas tutores inteligentes que poseen capacidad para reconocer y tratar emociones y/o afectos (Arroyo et al., 2009; D’Mello et al., 2009; Forbes-Riley & Litman, 2009; D’Mello et al., 2011).

4.3 Sistemas reconocedores de emociones en rostros

En esta sección se presentan algunas técnicas o métodos desarrollados para la implementación de sistemas para el reconocimiento automático de emociones a partir de rostros humanos.

Reconocimiento de caras

Para el reconocimiento de caras, un sistema computacional recibe una entrada, normalmente una imagen o video, y realiza un proceso para determinar si en la imagen se encuentran caras humanas o no. Su estudio es un tópico muy importante en la biometría, donde se han hecho investigaciones al respecto (Zhao et al., 2003; Ruiz-del-Solar & Navarrete, 2005; Delac & Grgic, 2007; Ponce & Karahoca, 2009).

Los términos “detección”, “identificación”, “autenticación” y “reconocimiento de caras” algunas veces se interpretan de forma similar, pero es importante señalar sus diferencias:

- La detección es el proceso para determinar si existe en una imagen o video un objeto que parezca una cara.

- La identificación es el proceso que permite identificar a qué persona pertenece la cara detectada en la imagen o video. Generalmente este proceso requiere un conjunto de imágenes o datos para identificar personas en específico.

- La autenticación es el proceso para verificar que la persona que está siendo detectada es en realidad ella y no otra.

- El reconocimiento viene a ser todo el proceso que involucra a los tres procesos de detección, identificación y autenticación.

De acuerdo con Chellapa, Wilson y Sirohey (1995), las investigaciones en reconocimiento facial de imágenes se dividen en dos categorías:

- Métodos holísticos: estos métodos tratan a la imagen como un todo y el análisis se lleva a cabo sin intentar encontrar puntos individuales. La cara es reconocida como una sola entidad sin identificar regiones. Los métodos holísticos suelen usar técnicas de análisis estadístico, redes neuronales y transformaciones. Estos métodos por lo general requieren de una gran cantidad de datos de entrenamiento, y su ventaja es que, al usar toda la cara, no hay pérdida de datos por omisión, como sucede en otras técnicas. Sin embargo, solo son efectivos para reconocer caras desde una vista frontal.

- Métodos basados en características: estos se basan en la identificación de ciertos puntos importantes de la cara, como los ojos, la nariz, la boca, etc. La localización de esos puntos puede ser determinada y usada para computar relaciones geométricas entre esos puntos. Por lo tanto, el procesamiento se realiza de forma independiente para los ojos, la nariz, la boca y otros puntos importantes, y después se combinan para llevar a cabo el reconocimiento facial.

Técnicas de reconocimiento facial de emociones

Muchos estudios realizados para el reconocimiento de emociones en rostros humanos están basados en el trabajo de las seis emociones básicas propuestas por Ekman (1999). Esto se debe principalmente a que las emociones básicas representan propiedades universales entre personas de diferentes regiones, y además existe disponibilidad de diversos conjuntos de datos (dataset) digitales de rostros humanos o material relevante que se puede utilizar para el entrenamiento de sistemas automáticos de reconocimiento de emociones. Por otra parte, algunos investigadores también realizan esfuerzos para detectar estados afectivos no básicos usando expresiones faciales deliberadas que incluyen fatiga (Ji et al., 2006), dolor (Littlewort et al., 2007) y estados mentales como concentración, desacuerdo, interés, frustración e inseguridad (Kaliouby & Robinson, 2005). Los trabajos de investigación en el área de emociones y afecto se han orientado al análisis automático de datos de expresiones faciales espontáneas o no deliberadas, tal como se muestra en los trabajos de Cohn (2006), Bartlett et al. (2006), Littlewort et al. (2007).

A continuación, se describen dos técnicas utilizadas para el reconocimiento de emociones en rostros humanos.

- Reconocimiento de emociones basado en temperatura de la cara. La temperatura corporal, y específicamente la temperatura del rostro, se usa para el reconocimiento de emociones. Los autores Khan, Ward, e Ingleby presentaron en 2009 un trabajo para reconocer emociones positivas y negativas utilizando la temperatura del rostro. La técnica consiste en captar imágenes del rostro y medir el calor corporal o temperatura de la cara cuando se presentan diferentes expresiones faciales. La figura 16 presenta un ejemplo de tres imágenes captadas de una misma persona con diferentes expresiones faciales, las cuales presentan, de izquierda a derecha, los estados emocionales neutral, de felicidad y de tristeza. Las imágenes están acompañadas por la representación de calor corporal utilizando infrarrojo.

Después de una serie de pruebas, los autores definieron ciertos puntos de características termales faciales o facial thermal feature points (ftfp por sus siglas en inglés), los cuales tienen relación con los músculos del rostro y cambian su temperatura dependiendo del movimiento. La Figura 17 presenta a la izquierda el conjunto de puntos ftfp sobre la imagen de un rostro humano y a la derecha el conjunto de puntos ftfp sobre un mapa de músculos faciales. - Reconocimiento de expresiones faciales utilizando au. Este método se basa en las unidades de acción (au por sus siglas en inglés) que se determinan respecto a la contracción o relajación de ciertos músculos de la cara cuando se despliega una emoción. Ekman y Friesen (1978) desarrollaron el sistema de codificación de acciones de los músculos de la cara o “facial action coding system”, el cual actualizaron en 2002 (Ekman et al., 2002) y contiene 46 au para los músculos del rostro. En Valstar & Pantic (2006) se presenta un sistema que permite el reconocimiento de expresiones faciales de una forma fácil y robusta. El método de identificación se centra en detectar un subconjunto de 15 au de las 46 au definidas en el sistema de codificación de acciones de los músculos de la cara definido por Ekman y colegas. Valstar y Pantic solo consideraron las 15 au más importantes a su criterio para reconocer emociones. Una de las ventajas de esta técnica es la facilidad de reconocer emociones espontáneas.

Figura 16. Imágenes visibles e infrarrojas

Fuente: Khan et al. (2009).

Figura 17. FTFP sobre cara humana y sobre mapa de los músculos faciales humanos

Fuente: Khan et al. (2009).

4.4 Sistemas reconocedores de emociones en voz

El reconocimiento automático de emociones a partir de la voz humana se fundamenta en el hecho de que los cambios en el sistema nervioso autónomo alteran indirectamente el habla, y esa información se aprovecha para producir sistemas capaces de reconocer emociones basados en la extracción de características en el habla. Por ejemplo, el habla o voz producida en un estado de temor, enojo o felicidad, se vuelve más rápida y más fuerte, precisamente enunciada con un rango de tono más alto y más ancho. El procesamiento de emociones en la voz reconoce el estado emocional de un usuario al analizar los patrones en esa voz. Para ello, los parámetros vocales y las características prosódicas, como las variables de tono y la velocidad de la voz, se analizan por medio de técnicas de reconocimiento de patrones (Dellaert et al., 1996; Lee et al., 2001).

Los sistemas de reconocimiento de emociones en el habla tradicionalmente se dividen en tres partes principales: procesamiento de la señal, extracción de características y clasificación.

Procesamiento de la señal

El procesamiento de la señal involucra la digitalización de la señal grabada, potencialmente un preprocesamiento de filtrado en la señal ya digitalizada, y por último la segmentación de la entrada de la señal en pequeñas unidades para el procesamiento posterior.

Extracción de características

El objetivo del cálculo o extracción de características es encontrar aquellas propiedades de la señal acústica previamente digitalizada y preprocesada que tengan las características necesarias para reconocer emociones.

La señal de habla puede ser asumida como una onda de sonido que es periódica por momentos. Como todas las ondas de sonido, esta tiene ciertas propiedades como amplitud, tiempo y frecuencia que sirven para caracterizarla y que ayudan a identificar las diferentes emociones. A continuación, se describen algunas de las medidas básicas de las características usadas para el reconocimiento automático de emociones usando la voz humana (Clark et al., 2007).

- Pitch. El término “pitch” se refiere a la percepción del oído respecto a la intensidad del tono. Esta es una propiedad muy obvia del habla, incluso para los que no son expertos, y a veces es considerada erróneamente como la más importante para la identificación de emociones.

- Formantes. Los formantes son la máxima local en el espectro de frecuencia causados por la resonancia durante la producción del habla.

- Volumen. El volumen es la fuerza del sonido tal como la percibe el oído humano. Es difícil medirlo directamente, por lo tanto, la energía de la señal a menudo es usada como una característica relacionada. La energía puede ser calculada desde el espectro después de aplicarle la transformada de Fourier a la señal original.

- Coeficientes “cepstrales” de frecuencia en escala de Mel (mfcc). Son representaciones paramétricas de la señal de habla, muy comúnmente usadas en el reconocimiento automático del habla, y que se usan con gran éxito en la identificación y reconocimiento de emociones.

- Wavelets. La transformada “wavelet” contiene muchos aspectos de la señal de habla, en particular información en la sincronización la cual es muy importante para el reconocimiento de emociones.

- Duración y tasa de habla o velocidad de habla. La medida del tiempo juega un papel muy importante en la expresión de emociones. Esto implica la duración de las unidades de habla, como la longitud de la declaración, el promedio de longitud de una palabra en una declaración o el promedio de longitud de una sílaba dentro de una palabra.

- Calidad de voz. La calidad de la voz puede sonar dificultosa, quebrada, áspera o en forma de susurro. Las relaciones de la calidad de voz con las emociones son diversas. Por ejemplo, las respiraciones dificultosas pueden resultar en que la emoción detectada sea de excitación.

Clasificación

El último paso es clasificar la emoción encontrada o identificada de acuerdo con las características extraídas en la voz. Una vez que han sido extraídas las características principales que son necesarias para reconocer emociones, se aplica alguna técnica de inteligencia artificial para la clasificación de la emoción. Algunas de las técnicas más populares para el reconocimiento son las redes neuronales artificiales, las máquinas de soporte vectorial (svm por sus siglas en inglés), los árboles de decisión, los modelos ocultos de Markov y los algoritmos de votación. Cada una de estas técnicas tiene ventajas y desventajas. Sin embargo, la calidad del corpus o base de datos con voces que se utiliza para que el sistema reconocedor de emociones “aprenda” a clasificarlas, influye notablemente en la tasa de éxito que el reconocimiento alcanza.

4.5 Sistemas reconocedores multimodales

Un sistema multimodal para reconocer emociones combina dos o más entradas para percepción de los datos con el objetivo principal de incrementar la tasa de reconocimiento exitoso. Cuando se mencionan las entradas de percepción de los datos es posible realizar una semejanza con los sentidos (vista, oído, tacto, etc.) por medio de los cuales el ser humano percibe información que le provoca emociones. En un sistema multimodal de reconocimiento automático de emociones, la entrada puede ser una cámara web, un micrófono, un mouse o un sensor especial para detectar, por ejemplo, calor o sudoración en la piel.

Existen diversas técnicas de reconocimiento multimodal (Zeng et al., 2008). El uso de sistemas multimodales para el reconocimiento de emociones fue inicialmente estudiado e implementado por Busso et al. (2004), quienes proponen un sistema bimodal para la identificación de emociones a través de la cámara y del audio de las expresiones. En Arroyo et al. (2009) y Woolf et al. (2007) los autores construyen un sistema multimodal para reconocer el estado afectivo de un grupo de alumnos. Los autores definieron cuatro estados afectivos, a saber: confianza, frustración, emoción e interés. El sistema reconocedor contiene cuatro dispositivos de entrada que se utilizan para captar las señales del usuario (véase figura 18). Las señales se captan a través de una cámara para medir o reconocer expresiones faciales, un brazalete inalámbrico que mide la conductividad en la piel, un asiento y respaldo sensibles a la presión corporal y un ratón de presión para medir la presión sobre su botón. Todo el hardware de los sensores fue construido en la Universidad Estatal de Arizona (asu), con excepción de la cámara, que fue creada en el Instituto Tecnológico de Massachusetts (mit).

Cada uno de los dispositivos capta las señales de entrada, las cuales se procesan y como resultado se determina el estado afectivo del usuario, que puede ser confianza, frustración, emoción o interés.

Figura 18. Las cuatro interfaces de entrada

Fuente: Arroyo et al. (2009).